Những mô hình reasoning và agentic được nhắc đến nhiều nhất từ Moonshot AI, DeepSeek, Qwen và Z.ai, hiện đang “làm mưa làm gió”.

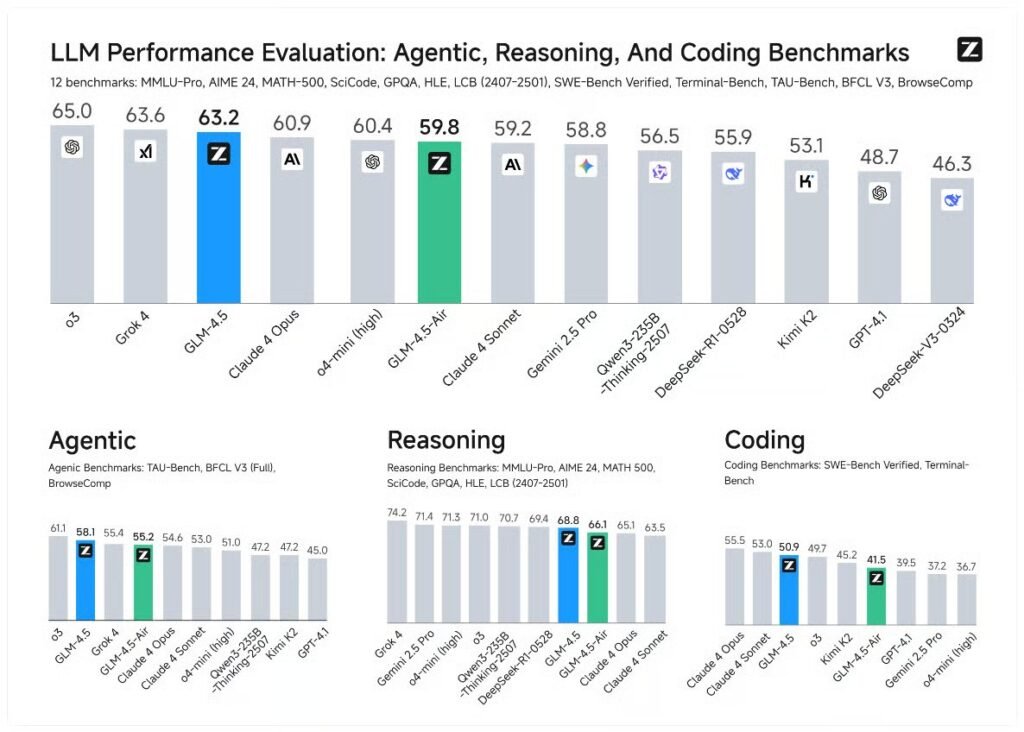

Tháng này thực sự là một kho báu các bản phát hành mô hình mới nóng hổi. Các công ty Trung Quốc – MoonshotAI, Qwen và Z.ai – đã biến nó thành một chiến trường của những mô hình agentic mạnh mẽ nhất từ trước đến nay. Không chỉ đánh dấu sự khởi đầu của một kỷ nguyên mới, nơi mà chỉ có khả năng suy luận thôi là chưa đủ, họ còn giữ cho lĩnh vực này luôn mở và dễ tiếp cận với tất cả mọi người. Một lần nữa, chúng ta được chứng kiến khoảnh khắc trọng đại khi công nghệ mã nguồn mở có thể sánh ngang, thậm chí vượt qua các mô hình đóng mà chúng ta từng quen thuộc.

Và, thật lòng mà nói, thật đáng tiếc cho Meta khi rút lui khỏi nguồn mở. Năm 2024, họ từng là “Linux của AI”. Thế mà sang năm 2025, bỗng nhiên lại thành “hãy cẩn trọng với những gì chúng ta mở ra”? Nghe không ổn chút nào.

Dù sao thì, đây là thời điểm của những đổi mới trong agentic, và các mô hình Trung Quốc sẽ không để bạn cảm thấy nhàm chán.

Chúng ta sẽ bắt đầu với Kimi K2 – mô hình được nhắc tới nhiều nhất, sau đó quay lại với DeepSeek-R1 – tiêu chuẩn vững chắc cho các mô hình suy luận, và cuối cùng khám phá những cái tên mới nhất Qwen3, Qwen3-Coder, và GLM-4.5. Hãy cùng theo dõi bản phân tích thú vị này.

Trong số hôm nay, chúng ta sẽ đề cập đến:

- Kimi K2 – Đại sứ của Trí tuệ Agentic

- Các đổi mới độc quyền (MuonClip optimizer, dữ liệu tổng hợp và kỹ thuật diễn đạt lại là chìa khóa, Self-critic – bước tiến đặc biệt trong mô hình hóa phần thưởng cho các tác vụ mở)

- Thành tựu nổi bật của Kimi K2

- DeepSeek-R1: Tiêu chuẩn suy luận

- Qwen3 – mô hình với khả năng kiểm soát chế độ suy nghĩ

- Kiến trúc và chiến lược huấn luyện

- Kết quả của Qwen3-235B

- Qwen3-Coder là gì?

- GLM-4.5 – bản phát hành nóng nhất từ Z.ai

- Cách GLM-4.5 hoạt động

- Những khả năng thực sự của GLM-4.5

- Kết luận: So sánh các mô hình

- Nguồn và tài liệu tham khảo thêm

Kimi K2 – Đại sứ của Trí tuệ Agentic

Kimi K2 hiện là mô hình MoE khổng lồ được nhắc tới nhiều nhất, ra mắt vào ngày 12/7, đánh dấu sự chuyển hướng sang Trí tuệ Agentic. Đây là kết quả từ chuyên môn và quyết tâm của nhóm nghiên cứu Moonshot AI trong việc xây dựng công nghệ AI tiên tiến, ưu tiên khả năng ghi nhớ ngữ cảnh dài không mất mát và cá nhân hóa. Điều này đồng nghĩa với khả năng ghi nhớ hoàn hảo, trung thực toàn bộ hội thoại. Các sản phẩm AI gốc (AI-native) được xây dựng trên nguyên tắc này có thể mang lại trải nghiệm người dùng tùy chỉnh cao mà không cần tinh chỉnh mô hình truyền thống.

Vậy những đổi mới mà Kimi K2 mang đến cho thế giới AI là gì? Đây thực sự là một trong những mô hình quan trọng nhất năm nay, đánh dấu “thời khắc agentic” tương tự như DeepSeek-R1 đã làm với suy luận. Nó nhanh chóng trở thành tiêu chuẩn mới cho hành vi agentic nhờ các quyết định kỹ thuật sau:

- MuonClip optimizer được xây dựng riêng để giữ cho quá trình học ổn định và cho phép huấn luyện trên khối lượng dữ liệu khổng lồ – 15,5 nghìn tỷ token.

- Hệ thống pipeline dữ liệu tổng hợp quy mô lớn tập trung vào việc xây dựng năng lực agentic cho Kimi K2.

- Khả năng học từ chính đầu ra của mình trong các câu hỏi mở thông qua Self-Critique Rubric Reward.

Các đổi mới độc quyền

Đầu tiên, hãy nói một chút về kiến trúc của Kimi K2. Đây là một mô hình MoE được mở rộng tới 1,04 nghìn tỷ tham số, nhưng chỉ kích hoạt 32 tỷ tham số tại mỗi thời điểm. Nó nâng mức độ sparsity lên 48, sử dụng tổng cộng 384 expert, kích hoạt 8 expert cho mỗi lượt forward pass, mà không tăng chi phí tính toán.

Mô hình của Moonshot AI sử dụng Multi-head Latent Attention (MLA), có kích thước ẩn 7168, với các lớp expert dùng trạng thái ẩn 2048 chiều. Nó cũng áp dụng chiến lược cân bằng số lượng attention heads để giữ cho việc suy luận trên ngữ cảnh dài khả thi (nhớ rằng đây là khái niệm lossless long context). Kimi K2 sử dụng 64 attention heads, so với 128 của DeepSeek-V3 chẳng hạn. Số lượng attention ít hơn giúp tăng tốc quy trình.

MuonClip optimizer

Bắt đầu với MuonClip – bộ tối ưu hóa tùy chỉnh được sử dụng để huấn luyện Kimi K2 ngay từ đầu…

MuonClip optimizer

Bắt đầu với MuonClip – bộ tối ưu hóa tùy chỉnh được sử dụng để huấn luyện Kimi K2 ngay từ giai đoạn đầu. Đây là một kỹ thuật giúp giữ cho quá trình học ổn định trong các mô hình cực lớn, đồng thời ngăn chặn hiện tượng gradient explosion hoặc vanishing gradient khi xử lý dữ liệu khổng lồ. MuonClip cho phép Kimi K2 được huấn luyện trên tập dữ liệu khổng lồ 15,5 nghìn tỷ token mà vẫn duy trì chất lượng học ổn định.

Hệ thống dữ liệu tổng hợp quy mô lớn

Một yếu tố then chốt khác của Kimi K2 là pipeline dữ liệu tổng hợp được xây dựng để tập trung phát triển năng lực agentic. Quy trình này tạo ra các tình huống và kịch bản mô phỏng để mô hình luyện khả năng ra quyết định, lập kế hoạch và tự quản lý hành động — thay vì chỉ phản ứng bị động trước yêu cầu của người dùng. Dữ liệu tổng hợp còn được thiết kế đa dạng về ngữ cảnh và nhiệm vụ, giúp mô hình thích nghi với nhiều trường hợp thực tế.

Self-Critique Rubric Reward

Điểm đột phá tiếp theo là khả năng tự đánh giá và cải thiện câu trả lời của chính mình. Thông qua Self-Critique Rubric Reward, Kimi K2 sẽ tự chấm điểm cho các phản hồi trong những câu hỏi mở, so sánh với tiêu chí chất lượng đã định sẵn, rồi dùng phản hồi này để tinh chỉnh bản thân. Điều này giúp mô hình không chỉ học từ dữ liệu huấn luyện, mà còn liên tục cải thiện qua quá trình sử dụng thực tế.

DeepSeek-R1 – Tiêu chuẩn suy luận (Reasoning baseline)

Nếu Kimi K2 là tiêu chuẩn mới cho hành vi agentic, thì DeepSeek-R1 chính là nền tảng cho các mô hình suy luận. Được tối ưu hóa mạnh cho khả năng lập luận logic và toán học, DeepSeek-R1 tập trung vào độ chính xác và tính nhất quán trong suy nghĩ hơn là các hành vi agentic. Đây là lựa chọn lý tưởng khi bạn cần một mô hình đưa ra đáp án chính xác, chặt chẽ và có thể giải thích được.

Qwen3 – Mô hình với khả năng kiểm soát chế độ suy nghĩ

Điểm nổi bật của Qwen3 là khả năng chuyển đổi linh hoạt giữa chế độ “suy nghĩ” và “không suy nghĩ” tùy vào nhiệm vụ.

-

Chế độ “suy nghĩ” (thinking mode) cho phép mô hình lập luận nhiều bước trước khi trả lời.

-

Chế độ “không suy nghĩ” (non-thinking mode) giúp trả lời nhanh cho các tác vụ đơn giản, tiết kiệm thời gian và tài nguyên.

Kiến trúc & chiến lược huấn luyện

Qwen3 được xây dựng với trọng tâm là khả năng đa ngôn ngữ, xử lý tốt nhiều hệ thống ký tự (Latin, Hán, Ả Rập, Cyrillic…) và tương thích cao với nhiều kiểu input phức tạp.

Qwen3-235B

Phiên bản 235B của Qwen3 là mô hình quy mô lớn nhất trong dòng sản phẩm này, với khả năng hiểu ngữ cảnh dài và hiệu suất vượt trội trên nhiều benchmark đa ngôn ngữ.

Qwen3-Coder – Chuyên gia lập trình ở quy mô repo

Được tối ưu hóa cho lập trình ở quy mô kho mã (repository scale), Qwen3-Coder có khả năng hiểu và xử lý toàn bộ dự án phần mềm, đề xuất chỉnh sửa hợp lý, thậm chí tự động viết và kiểm thử mã theo yêu cầu. Khả năng agentic cho phép mô hình chủ động điều hướng dự án và thực hiện nhiều tác vụ mà không cần người dùng hướng dẫn từng bước.

GLM-4.5 – Bản phát hành nóng nhất từ Z.ai

Phiên bản GLM-4.5 của Z.ai là một trong những mô hình agentic “rành công cụ” nhất hiện nay. Nó được thiết kế để sử dụng thành thạo nhiều công cụ bên ngoài (API, cơ sở dữ liệu, ứng dụng SaaS…) và kết hợp chúng trong quy trình làm việc liên tục.

Cách GLM-4.5 hoạt động

GLM-4.5 tích hợp cơ chế lập kế hoạch nhiều bước và tương tác linh hoạt với công cụ, giúp nó hoàn thành các quy trình phức tạp từ A–Z mà ít cần người dùng can thiệp.

Những khả năng thực sự của GLM-4.5

Ngoài khả năng agentic, GLM-4.5 còn có tốc độ xử lý ấn tượng, khả năng ngữ cảnh dài và hiệu quả cao trong các nhiệm vụ yêu cầu phối hợp nhiều nguồn thông tin.

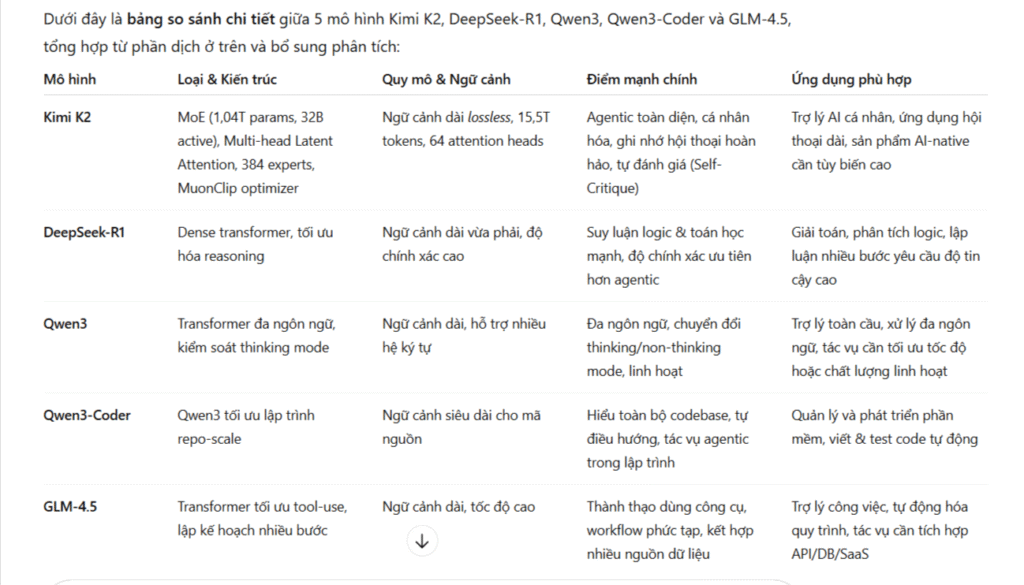

Kết luận – So sánh các mô hình

-

Kimi K2 → Cân bằng toàn diện, mạnh về agentic & ngữ cảnh dài.

-

DeepSeek-R1 → Tập trung tối đa vào độ chính xác suy luận.

-

Qwen3 → Kiểm soát chế độ suy nghĩ, mạnh về đa ngôn ngữ.

-

Qwen3-Coder → Lập trình quy mô lớn với hành vi agentic.

-

GLM-4.5 → Thành thạo công cụ, xử lý quy trình phức tạp hiệu quả.

Các mô hình Trung Quốc đang chứng minh rằng nguồn mở vẫn có thể cạnh tranh sòng phẳng, thậm chí vượt qua các mô hình đóng – và đây là thời điểm bùng nổ của trí tuệ agentic.